In der digitalisierten Geschäftswelt entscheidet eine solide IT-Infrastruktur maßgeblich über Effizienz, Skalierbarkeit und Wettbewerbsfähigkeit. Der strategische Aufbau dieser technischen Basis ist keine einmalige Aufgabe, sondern ein kontinuierlicher Prozess, der weitreichende Auswirkungen auf den Unternehmenserfolg hat. Dieser Artikel beleuchtet die wesentlichen Aspekte beim Aufbau einer zukunftssicheren IT-Infrastruktur und gibt praxisnahe Handlungsempfehlungen für eine erfolgreiche Implementierung.

Inhaltsverzeichnis

- Die Grundlagen einer modernen IT-Infrastruktur

- Komponenten einer modernen IT-Infrastruktur

- Strategien für den erfolgreichen Infrastrukturaufbau

- On-Premise vs. Cloud: Die richtige Balance finden

- Zukunftssichere IT-Infrastruktur: Trends und Entwicklungen

- Fazit: Der strategische Aufbau entscheidet

- Häufig gestellte Fragen

Die Grundlagen einer modernen IT-Infrastruktur

Eine IT-Infrastruktur umfasst die Gesamtheit aller Hardware, Software, Netzwerke und Dienste, die für den Betrieb der Unternehmens-IT erforderlich sind. Laut einer Studie des Digitalverbands Bitkom investieren deutsche Unternehmen zunehmend in ihre digitale Infrastruktur, um Geschäftsprozesse zu optimieren und neue Geschäftsmodelle zu ermöglichen. Allein im Jahr 2022 stiegen die IT-Investitionen um durchschnittlich 8,3% gegenüber dem Vorjahr.

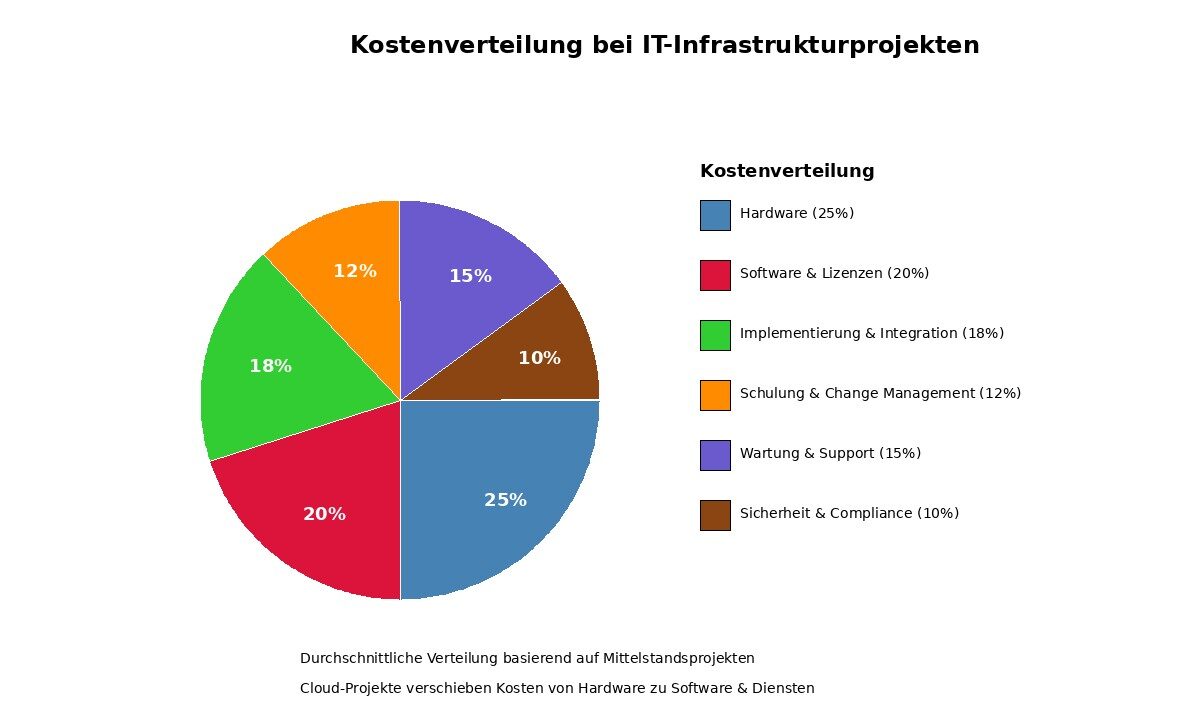

Kostenverteilung bei IT-Infrastrukturprojekten – Quelle: Statista und KPMG IT-Budgetstudien 2024

- Welche Geschäftsprozesse sollen unterstützt werden?

- Wie viele Mitarbeiter müssen mit der Infrastruktur arbeiten?

- Welche Skalierbarkeitsanforderungen bestehen?

- Welche Sicherheitsanforderungen müssen erfüllt werden?

Komponenten einer modernen IT-Infrastruktur

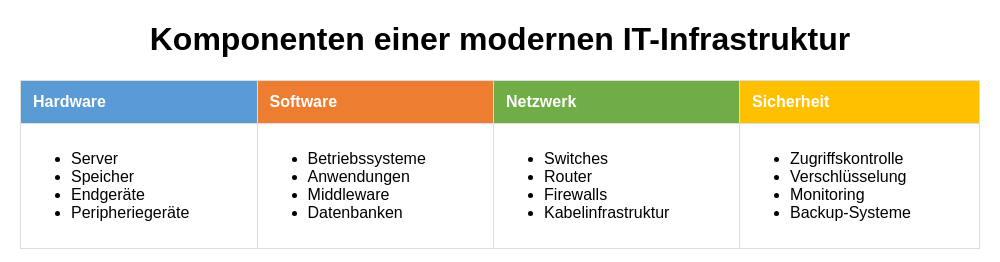

Der Aufbau einer leistungsfähigen IT-Infrastruktur erfordert das perfekte Zusammenspiel verschiedener Komponenten. Jedes Element muss sorgfältig ausgewählt und optimal in das Gesamtsystem integriert werden. Zu den Hauptkomponenten gehören Hardware, Software, Netzwerk und Sicherheitssysteme.

Komponenten einer modernen IT-Infrastruktur (Quelle: BSI IT-Grundschutz Compendium)

Hardware-Komponenten

Die Hardware bildet die physische Grundlage jeder IT-Infrastruktur. Hierzu zählen:Server und Rechenleistung

Je nach Unternehmensgröße und Anforderungen können dedizierte Server, Blade-Server oder virtuelle Server zum Einsatz kommen. Moderne Infrastrukturen setzen zunehmend auf Virtualisierungstechnologien, um Ressourcen effizienter zu nutzen. Eine Studie von VMware zeigt, dass Unternehmen durch Servervirtualisierung ihre Hardware-Kosten um bis zu 50% reduzieren können.Speicherlösungen

Von lokalen Festplatten über NAS (Network Attached Storage) bis hin zu SAN (Storage Area Network) – die richtige Speicherlösung hängt von Datenmenge, Zugriffsgeschwindigkeit und Sicherheitsanforderungen ab. Besonders bei datenintensiven Anwendungen kann die Wahl der richtigen Speichertechnologie erhebliche Auswirkungen auf die Gesamtleistung haben.Netzwerkkomponenten

Router, Switches und Firewalls bilden das Rückgrat der Kommunikation. Eine durchdachte Netzwerkarchitektur mit redundanten Komponenten sorgt für hohe Verfügbarkeit und Ausfallsicherheit. Moderne Netzwerke sollten zudem Software-Defined Networking (SDN) unterstützen, um flexibler auf Änderungen reagieren zu können.Endgeräte

Arbeitsplatzrechner, Laptops, Tablets und andere Endgeräte sind die Schnittstelle zwischen Mitarbeitern und der IT-Infrastruktur. Hier gilt es, eine Balance zwischen Standardisierung (für einfachere Wartung) und individuellen Anforderungen zu finden. Die Absicherung dieser Endpunkte ist besonders wichtig – moderne Endpoint Security-Lösungen bieten hier umfassenden Schutz vor Bedrohungen.Software-Infrastruktur

Die Software-Infrastruktur umfasst alle Programme und Dienste, die auf der Hardware ausgeführt werden und bildet das logische Fundament für alle Geschäftsanwendungen.Betriebssysteme

Sie bilden die Schnittstelle zwischen Hardware und Anwendungssoftware. Die Wahl zwischen Windows, Linux oder anderen Systemen sollte auf Basis der Unternehmensanforderungen getroffen werden. Wichtig ist dabei nicht nur die Funktionalität, sondern auch die langfristige Unterstützung durch den Hersteller.Middleware

Diese Software verbindet verschiedene Anwendungen und ermöglicht deren Kommunikation untereinander. Besonders in heterogenen Umgebungen spielt Middleware eine entscheidende Rolle für die nahtlose Integration verschiedener Systeme.Anwendungssoftware

Hierzu zählen Standardanwendungen wie Office-Pakete, aber auch branchenspezifische Software und Eigenentwicklungen. Die Auswahl sollte sich an den Geschäftsprozessen orientieren und Schnittstellen zu anderen Systemen berücksichtigen.Datenbanksysteme

Sie bilden das Rückgrat für die Datenspeicherung und -verwaltung. Je nach Anforderungen an Skalierbarkeit, Performance und Verfügbarkeit kommen relationale Datenbanken (wie MySQL oder Microsoft SQL Server) oder NoSQL-Datenbanken (wie MongoDB oder Cassandra) zum Einsatz. Ein effektives Software Management ist entscheidend für die Wartung und Aktualisierung dieser Komponenten, um Sicherheitslücken zu schließen und neue Funktionen zu implementieren.Strategien für den erfolgreichen Infrastrukturaufbau

Der Aufbau einer IT-Infrastruktur ist ein komplexes Unterfangen, das strategisches Vorgehen erfordert. Folgende Ansätze haben sich in der Praxis bewährt und führen nachweislich zu besseren Ergebnissen.1. Bedarfsgerechte Planung

Eine gründliche Planung ist der Schlüssel zum Erfolg. Dabei sollten nicht nur aktuelle, sondern auch zukünftige Anforderungen berücksichtigt werden. Die IT-Infrastrukturplanung sollte eng mit der Geschäftsstrategie verzahnt sein und regelmäßig überprüft werden. Ein mittelständisches Produktionsunternehmen aus Bayern konnte durch eine vorausschauende Infrastrukturplanung seine IT-Kosten um 23% senken, während gleichzeitig die Systemverfügbarkeit auf 99,9% stieg. Der Schlüssel zum Erfolg: Eine modulare Architektur, die schrittweise Erweiterungen ohne komplette Neuinstallationen ermöglichte.2. Modularität und Skalierbarkeit

Eine modulare Architektur ermöglicht schrittweise Erweiterungen ohne komplette Neuinstallationen. Dies reduziert Kosten und minimiert Betriebsunterbrechungen. Besonders für wachsende Unternehmen ist Skalierbarkeit ein entscheidender Faktor. Die Stadtwerke Münster haben bei ihrer Infrastrukturmodernisierung auf ein modulares Konzept gesetzt. “Durch den modularen Ansatz konnten wir unsere IT-Infrastruktur schrittweise modernisieren, ohne den laufenden Betrieb zu beeinträchtigen”, erklärt IT-Leiter Michael Schürmann in einem Fachbeitrag für den Verband kommunaler Unternehmen (VKU). “Zudem können wir nun flexibel auf neue Anforderungen reagieren, ohne die Grundarchitektur in Frage stellen zu müssen.”3. Standardisierung

Standardisierte Komponenten und Prozesse vereinfachen Wartung, Support und Erweiterungen. Sie reduzieren Komplexität und Fehleranfälligkeit und ermöglichen effizientere Schulungen. Laut einer Gartner-Studie können Unternehmen durch konsequente Standardisierung ihre IT-Betriebskosten um bis zu 25% senken. Die Standardisierung sollte sich nicht nur auf Hardware und Software erstrecken, sondern auch auf Prozesse und Dokumentation. Ein einheitliches Change-Management, standardisierte Betriebshandbücher und klare Verantwortlichkeiten erhöhen die Transparenz und reduzieren Fehlerquellen.4. Sicherheit als Grundprinzip

Sicherheit muss von Anfang an integraler Bestandteil der Infrastrukturplanung sein, nicht nachträgliches Add-on. Ein umfassendes Sicherheitskonzept umfasst technische Maßnahmen, organisatorische Regelungen und Mitarbeitersensibilisierung. Das Bundesamt für Sicherheit in der Informationstechnik (BSI) empfiehlt in seinem IT-Grundschutz-Kompendium einen mehrschichtigen Sicherheitsansatz, der Prävention, Detektion und Reaktion umfasst. Regelmäßige Vulnerability Scans und Incident Response-Pläne sind unverzichtbar.5. Total Cost of Ownership (TCO) betrachten

Bei Investitionsentscheidungen sollten nicht nur die Anschaffungskosten, sondern die Gesamtbetriebskosten über den gesamten Lebenszyklus betrachtet werden. Dies umfasst Wartung, Support, Energiekosten, Schulungen und eventuelle Ausfallkosten. Eine Analyse des Fraunhofer-Instituts für Produktionstechnik und Automatisierung (IPA) zeigt, dass die Anschaffungskosten bei IT-Infrastrukturprojekten durchschnittlich nur 40% der Gesamtkosten über einen Zeitraum von fünf Jahren ausmachen. Die restlichen 60% entfallen auf Betrieb, Wartung und Anpassungen.On-Premise vs. Cloud: Die richtige Balance finden

Die Entscheidung zwischen lokaler Infrastruktur und Cloud-Lösungen ist keine Entweder-Oder-Frage mehr. Hybride Ansätze, die die Vorteile beider Welten kombinieren, setzen sich zunehmend durch.| Kriterium | On-Premise | Cloud | Hybrid |

|---|---|---|---|

| Kontrolle | Vollständige Kontrolle über Infrastruktur und Daten | Kontrolle wird durch Service-Level-Agreements geregelt, weniger direkte Kontrolle | Ausgewogene Kontrolle, mit direkter Kontrolle über On-Premise-Komponenten |

| Kosten | Hohe Anfangsinvestitionen, konstante Betriebskosten | Niedrigere Anfangsinvestitionen, Pay-as-you-go-Modell kann zu unvorhersehbaren Kosten führen | Ausgewogen, potenziell höhere Kosten durch Verwaltung von On-Premise und Cloud |

| Skalierbarkeit | Begrenzt durch physische Infrastruktur, erfordert Planung und zusätzliche Investitionen | Hochskalierbar, kann schnell an Nachfrage angepasst werden | Skalierbar, für bestimmte Anwendungen durch On-Premise-Infrastruktur begrenzt |

| Sicherheit | Hoch, mit entsprechenden Sicherheitsmaßnahmen | Hoch, mit Abhängigkeit von den Sicherheitsmaßnahmen des Anbieters | Hoch, erfordert aber sorgfältige Integration zur Aufrechterhaltung der Sicherheit |

| Datenschutz | Vollständige Kontrolle, Daten bleiben in der eigenen Infrastruktur | Daten befinden sich in den Rechenzentren des Anbieters, möglicherweise an mehreren Standorten weltweit | Daten können aufgeteilt werden, wobei sensible Daten On-Premise bleiben und andere Daten in der Cloud |

Vorteile lokaler Infrastruktur

Lokale Infrastrukturen bieten maximale Kontrolle über Daten und Systeme, was besonders bei sensiblen Informationen wichtig ist. Sie ermöglichen maßgeschneiderte Lösungen und sind unabhängig von Internetverbindungen. Langfristig können sie bei konstanter Auslastung kostengünstiger sein als Cloud-Dienste. Besonders in regulierten Branchen wie dem Gesundheitswesen oder der Finanzindustrie spielen Compliance-Anforderungen eine wichtige Rolle bei der Entscheidung für On-Premise-Lösungen. Die Deutsche Kreditbank (DKB) betreibt beispielsweise ihre Kernbankensysteme weiterhin in eigenen Rechenzentren, während weniger kritische Anwendungen in die Cloud migriert wurden.Vorteile der Cloud

Cloud-Lösungen punkten mit Flexibilität, schneller Bereitstellung und einfacher Skalierbarkeit. Sie reduzieren Investitionskosten (CAPEX) zugunsten von Betriebskosten (OPEX) und entlasten die interne IT von Routineaufgaben. Moderne Cloud-Dienste bieten zudem hochprofessionelle Sicherheitsmaßnahmen. Der Cloud Monitor 2023 von KPMG und Bitkom Research zeigt, dass bereits 84% der deutschen Unternehmen Cloud-Computing nutzen. Die wichtigsten Gründe für den Einsatz sind höhere Flexibilität (68%), geringere IT-Kosten (65%) und ortsunabhängiger Datenzugriff (62%).Der hybride Ansatz

Für die meisten Unternehmen erweist sich ein hybrider Ansatz als optimal. Geschäftskritische Anwendungen und sensible Daten werden typischerweise lokal oder in Private-Cloud-Umgebungen betrieben, während Standard-Anwendungen in die Public Cloud migrieren können. Die Commerzbank hat im Rahmen ihrer Digitalisierungsstrategie einen hybriden Ansatz gewählt. “Wir nutzen Public-Cloud-Dienste für Anwendungen mit hohen Skalierbarkeitsanforderungen und behalten gleichzeitig kritische Systeme in unserer Private Cloud”, erläutert Commerzbank-CIO Jörg Hessenmüller in einem Interview mit der Computerwoche. “Dieser Ansatz gibt uns die nötige Flexibilität bei gleichzeitiger Kontrolle über sensible Daten.” Ein durchdachtes IT-Infrastrukturmanagement ist dabei entscheidend für den Erfolg. Es muss sicherstellen, dass die verschiedenen Umgebungen nahtlos zusammenarbeiten und einheitlich verwaltet werden können.Zukunftssichere IT-Infrastruktur: Trends und Entwicklungen

Um eine wirklich zukunftssichere IT-Infrastruktur aufzubauen, müssen aktuelle Trends und Entwicklungen berücksichtigt werden. Folgende Technologien und Konzepte werden die IT-Infrastruktur in den kommenden Jahren maßgeblich prägen:Edge Computing

Edge Computing verlagert Rechenleistung näher an den Ort der Datenentstehung. Dies reduziert Latenzzeiten und Bandbreitennutzung, was besonders für IoT-Anwendungen und Echtzeit-Analysen wichtig ist. Laut IDC werden bis 2025 etwa 55% aller Daten am Edge verarbeitet. Der Automobilzulieferer Bosch setzt bereits heute auf Edge Computing in seinen Produktionsanlagen. “Durch die Datenverarbeitung direkt an der Maschine können wir Produktionsprozesse in Echtzeit optimieren und Ausfälle frühzeitig erkennen”, berichtet Dr. Stefan Assmann, Leiter der Bosch Connected Industry, in einem Fachbeitrag für die VDI-Nachrichten.Zero Trust Security

Das Zero-Trust-Modell geht davon aus, dass kein Zugriff automatisch vertrauenswürdig ist – unabhängig davon, ob er von innerhalb oder außerhalb des Netzwerks erfolgt. Jeder Zugriff wird kontinuierlich überprüft und nur minimal notwendige Rechte werden gewährt. “In einer Welt mit verschwimmenden Netzwerkgrenzen ist Zero Trust nicht optional, sondern essenziell”, betont Prof. Dr. Christoph Meinel vom Hasso-Plattner-Institut in einem Beitrag für die Zeitschrift “IT-Sicherheit”. “Besonders in hybriden Arbeitsumgebungen mit Remote-Zugriff auf Unternehmensressourcen bietet dieser Ansatz deutlich besseren Schutz als traditionelle Perimeter-basierte Sicherheitsmodelle.”Automatisierung und KI

Automatisierung und KI revolutionieren das Infrastrukturmanagement. Von der automatischen Ressourcenskalierung bis zur prädiktiven Wartung – intelligente Systeme optimieren Betriebsabläufe und reduzieren manuelle Eingriffe. Dies verbessert nicht nur die Effizienz, sondern auch die Zuverlässigkeit durch Minimierung menschlicher Fehler. Die Deutsche Telekom nutzt KI-basierte Systeme für das Netzwerkmanagement. “Durch den Einsatz von KI können wir potenzielle Netzwerkprobleme erkennen, bevor sie zu Ausfällen führen”, erklärt Claudia Nemat, Vorstandsmitglied für Technologie und Innovation, in einem Interview mit dem Handelsblatt. “Das erhöht die Netzstabilität und reduziert gleichzeitig den Wartungsaufwand.”Infrastructure as Code (IaC)

Infrastructure as Code revolutioniert die Art und Weise, wie Infrastrukturen definiert, bereitgestellt und verwaltet werden. Statt manueller Konfiguration werden Infrastrukturkomponenten durch Code beschrieben, der versioniert, getestet und automatisiert ausgerollt werden kann. Dies erhöht die Konsistenz, reduziert Fehler und beschleunigt Bereitstellungsprozesse. “IaC ist der Schlüssel zu einer wirklich agilen Infrastruktur”, erklärt DevOps-Experte Florian Frühstück von der Deutschen Bahn in einem Fachbeitrag für das IT-Magazin “iX”. “Es überträgt die Prinzipien der Softwareentwicklung auf die Infrastrukturverwaltung und ermöglicht so eine deutlich höhere Geschwindigkeit bei gleichzeitig besserer Qualität.”Nachhaltigkeit und Green IT

Angesichts des steigenden Energiebedarfs von IT-Infrastrukturen gewinnen Nachhaltigkeitsaspekte zunehmend an Bedeutung. Energieeffiziente Hardware, optimierte Kühlsysteme und intelligentes Energiemanagement reduzieren nicht nur Kosten, sondern auch den ökologischen Fußabdruck. Laut einer Studie des Umweltbundesamtes kann der Energieverbrauch von Rechenzentren durch moderne Technologien und optimierte Betriebskonzepte um bis zu 50% gesenkt werden. Unternehmen wie Google und Microsoft haben sich bereits verpflichtet, ihre Rechenzentren bis 2030 komplett CO2-neutral zu betreiben.Fazit: Der strategische Aufbau entscheidet

Der Aufbau einer modernen IT-Infrastruktur ist kein einmaliges Projekt, sondern ein kontinuierlicher Prozess. In einer Zeit rasanter technologischer Entwicklungen muss die Infrastruktur flexibel, skalierbar und anpassungsfähig sein. Einige übergreifende Prinzipien haben sich als universell gültig erwiesen:- Die IT-Infrastruktur ist ein strategisches Asset, nicht nur ein Kostenfaktor

- Ein ganzheitlicher Ansatz führt zu besseren Ergebnissen als isolierte Optimierungen

- Sicherheit muss von Beginn an integraler Bestandteil der Planung sein

- Flexibilität und Skalierbarkeit sind entscheidend für langfristigen Erfolg

- Menschen und Prozesse sind genauso wichtig wie die Technologie selbst